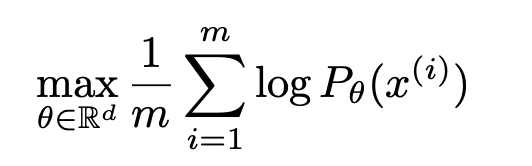

논문 링크 : https://arxiv.org/pdf/1701.07875.pdf 불러오는 중입니다... 아래 블로그가 정말 알기쉽게 설명이 잘 되어있습니다!! 많이 참고하였고 다른 분들도 참고하시면 좋을거 같습니다ㅎㅎ https://medium.com/@jonathan_hui/gan-wasserstein-gan-wgan-gp-6a1a2aa1b490 1. Introduction Unsupervised Learning(Self-supervised Learning)은 학습 데이터 x에 대한 정답 라벨 y가 존재한 것과는 달리, 데이터 x의 분포 P(x)를 직접 학습하겠다는 것이다. 이를 위해서 P(x)를 parameter θ에 대해 아래와 같이 표현하고, 이를 학습시킬 수 있다. 그러나 P(x)의 식을 직접 ..